Table of Contents

Saat mengelola website, ada banyak pengaturan teknis yang jarang diperhatikan, salah satunya adalah robots.txt. Padahal, file kecil ini punya peran penting dalam menentukan bagaimana mesin pencari seperti Google membaca dan menilai website Anda.

Secara sederhana, robot txt membantu “mengarahkan” mesin pencari agar fokus pada halaman yang penting dan mengabaikan bagian website yang tidak perlu ditampilkan di hasil pencarian.

Artikel ini akan membahas apa itu robot txt, fungsinya, serta mengapa pengaturannya penting untuk SEO dengan bahasa yang mudah dipahami. Yuk simak sampai akhir untuk mendapatkan penjelasan lengkapnya.

Apa Itu Robots.txt?

Robot txt, atau robots.txt, adalah file teks yang berisi aturan untuk bot mesin pencari. Bot ini adalah program otomatis yang bertugas mengunjungi website dan membaca isinya, proses yang sering disebut sebagai crawling.

Melalui file ini, pemilik website bisa memberi tahu bot:

- halaman mana yang boleh dibaca

- halaman mana yang sebaiknya diabaikan

File ini biasanya diletakkan di folder utama website dan bisa diakses melalui alamat:

namadomain.com/robots.txt

Penting untuk diketahui, robot txt bukan alat pengaman. File ini tidak mengunci halaman dari pengunjung, tetapi hanya mengatur apa yang dibaca oleh mesin pencari.

Fungsi Robots.txt pada Website

Mengatur Proses Crawling Mesin Pencari

Robot txt membantu mesin pencari memahami bagian website mana yang perlu diprioritaskan. Tanpa pengaturan ini, bot bisa membaca semua halaman tanpa pandang bulu, termasuk halaman yang tidak relevan untuk pencarian. Dengan arahan yang jelas, mesin pencari dapat fokus pada konten utama yang memang ingin ditampilkan kepada pengguna.

Menghindari Konten Ganda

Beberapa halaman di website dapat memiliki tampilan atau isi yang sangat mirip, seperti hasil pencarian internal, halaman filter produk, atau halaman dengan parameter URL berbeda. Pengaturan ini membantu membatasi halaman-halaman tersebut agar tidak dibaca mesin pencari, sehingga risiko konten ganda yang dapat menurunkan kualitas SEO dapat dihindari.

Mengurangi Beban Server

Setiap kunjungan bot mesin pencari tetap menggunakan sumber daya server. Jika bot terus-menerus mengakses halaman yang tidak penting, kinerja website bisa terpengaruh. Dengan robot txt, aktivitas crawling menjadi lebih efisien, sehingga beban server berkurang dan website tetap berjalan dengan lancar.

Menjaga Halaman Khusus Tetap Tidak Terindeks

Tidak semua halaman perlu muncul di hasil pencarian. Halaman admin, halaman pengujian, atau staging site biasanya hanya ditujukan untuk keperluan internal. Robot txt membantu memastikan halaman-halaman tersebut tidak dibaca oleh mesin pencari, sehingga hasil pencarian tetap bersih dan relevan bagi pengguna.

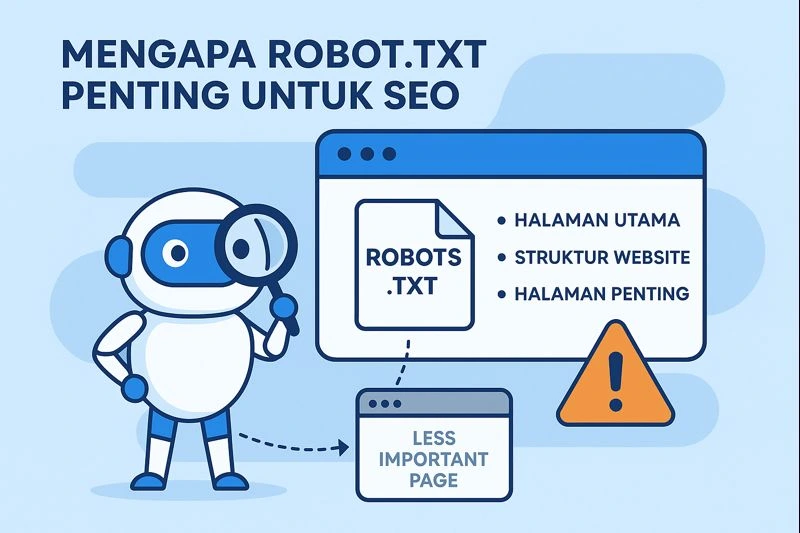

Mengapa Robots.txt Penting untuk SEO

Mesin pencari memiliki waktu dan sumber daya terbatas untuk membaca sebuah website. Jika tidak diarahkan, bot bisa menghabiskan waktunya pada halaman yang kurang penting.

Dengan pengaturan yang tepat:

- mesin pencari lebih fokus pada halaman utama

- struktur website lebih mudah dipahami

- halaman penting lebih cepat terindeks

Namun, kesalahan kecil dalam robot txt bisa berdampak besar. Misalnya, satu baris perintah yang salah dapat membuat seluruh website tidak muncul di Google. Karena itu, pemahaman dasar sangat penting.

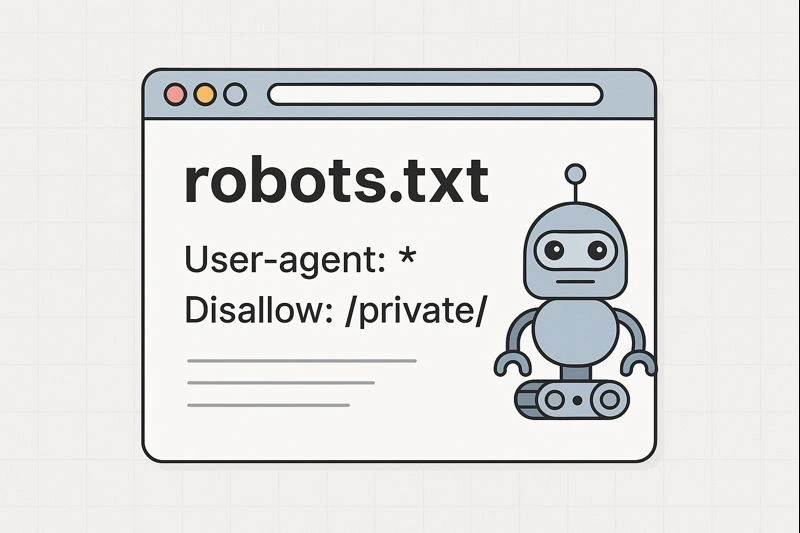

Istilah Penting dalam Robots.txt

| Directive | Fungsi | Contoh Penggunaan |

|---|---|---|

| User-agent | Digunakan untuk menentukan bot atau crawler mana yang harus mengikuti aturan dalam file robots.txt. | User-agent: Googlebot |

| Allow | Perintah untuk mengizinkan bot mengakses halaman atau direktori tertentu. | Allow: /blog/ |

| Disallow | Perintah untuk melarang bot mengakses halaman atau direktori tertentu. | Disallow: /private/ |

| Sitemap | Memberi tahu mesin pencari lokasi file sitemap agar struktur website lebih mudah dipahami. | Sitemap: https://domainanda.com/sitemap.xml |

Contoh Robots.txt Sederhana

Sebagai contoh, sebuah website ingin mengizinkan Google membaca seluruh halaman yang bersifat publik, tetapi tidak ingin halaman admin ikut dibaca oleh mesin pencari.

Dalam pengaturan robot txt, aturan tersebut berarti Google diperbolehkan mengakses semua halaman website, kecuali halaman yang berada di direktori admin. Dengan pengaturan seperti ini, konten utama tetap dapat muncul di hasil pencarian, sementara halaman pengelolaan website tidak ikut di crawl.

Contoh pengaturan robot txt yang digunakan:

User-agent: Googlebot

Allow: /

Disallow: /admin/

Instruksi di atas menunjukkan bahwa Googlebot diizinkan mengakses seluruh website, kecuali direktori /admin/.

Cara Membuat dan Mengatur Robots.txt

Menggunakan WordPress

Bagi pengguna WordPress, robot txt dapat dibuat dengan mudah menggunakan plugin SEO seperti:

- Yoast SEO

- All in One SEO

Melalui menu pengaturan plugin, Anda bisa mengatur Allow dan Disallow tanpa harus menulis kode secara manual.

Membuat Manual

Robot txt juga dapat dibuat menggunakan file teks sederhana, lalu diunggah ke folder utama website melalui hosting. Cara ini biasanya digunakan oleh pengguna yang sudah terbiasa mengelola file website secara langsung.

Berikut contoh struktur dasar robot txt yang umum digunakan pada website WordPress:

User-agent: *

Disallow: /wp-admin/

Allow: /wp-admin/admin-ajax.php

Sitemap: namadomain/sitemap.xml

Pada contoh tersebut, tanda bintang (*) berarti aturan berlaku untuk semua bot mesin pencari. Direktori /wp-admin/ dibatasi agar tidak dibaca crawler, sementara file admin-ajax.php tetap diizinkan karena dibutuhkan untuk fungsi website. Baris sitemap berfungsi memberi tahu mesin pencari lokasi peta website agar proses crawling dan indexing lebih efisien.

Hal Penting yang Perlu Diperhatikan

Tidak semua bot selalu mematuhi aturan robot txt, terutama bot yang tidak resmi. Selain itu, robot txt tidak bisa digunakan untuk mengamankan data penting. Untuk keamanan, tetap diperlukan pengaturan tambahan.

Kesalahan pengaturan juga perlu dihindari. Misalnya, perintah yang melarang seluruh website bisa membuat website hilang dari hasil pencarian. Selain itu, halaman yang diblokir robot txt masih bisa muncul di Google jika ditautkan dari website lain, meskipun isinya tidak ditampilkan.

Praktik Terbaik Menggunakan Robots.txt untuk SEO

Gunakan robot txt untuk membantu mesin pencari membaca website dengan lebih efisien, bukan untuk menyembunyikan informasi penting. Sertakan sitemap agar mesin pencari memahami struktur website, dan selalu periksa pengaturannya menggunakan Google Search Console.

Perbarui robot txt jika struktur website berubah, dan pastikan halaman utama tetap dapat diakses oleh mesin pencari.

Kesimpulan

Robots.txt merupakan elemen teknis penting dalam optimasi SEO website. Dengan pengaturan yang tepat, file ini membantu mesin pencari memahami struktur website, mengelola crawl budget, dan mempercepat proses indexing pada halaman-halaman penting. Di Pixie Digital, kami menerapkan pengaturan teknis SEO yang terstruktur dan relevan untuk membantu website berkembang secara berkelanjutan.